L'intelligenza artificiale è ormai una presenza onnipresente nella nostra vita quotidiana, da assistenti vocali a smartphone e chatbot avanzati come ChatGPT. Tuttavia, spesso la teoria che sta alla base di queste tecnologie, in particolare delle reti neurali profonde, è ancora poco chiara. Un recente studio condotto dall'Università degli Studi di Parma ha gettato nuova luce su questo affascinante campo, offrendo una teoria innovativa che promette di migliorare la comprensione e l'applicazione pratica di queste reti.

Introduzione:

Dalla penna dei ricercatori dell'Università di Parma emerge uno studio che coniuga la Fisica statistica con il deep learning, aprendo nuove vie nella comprensione delle reti neurali profonde. Questo lavoro, pubblicato su "Nature Machine Intelligence", getta le basi per una teoria che predice con precisione le performance di una particolare classe di reti neurali profonde, le cosiddette "fully-connected".

La Teoria Innovativa:

La teoria proposta dal team di ricercatori, guidato dal Professor Pietro Rotondo, offre una prospettiva unica sulla capacità di astrazione delle reti neurali profonde. Attraverso parametri fondamentali, come la larghezza dei "layer nascosti" e le funzioni di attivazione, insieme ai dati di addestramento, è possibile predire le performance di una rete con notevole accuratezza. Questo rappresenta un passo significativo nel colmare il divario tra teoria e applicazioni pratiche dell'intelligenza artificiale.

Applicazioni Pratiche e Implicazioni Future:

La scoperta non solo aumenta la comprensione delle reti neurali profonde ma apre la strada a sistemi più complessi e vicini a quelli che usiamo quotidianamente. L'innovazione arriva nel contesto del progetto PNRR MNESYS, con la partecipazione di ricercatori provenienti da istituzioni italiane ed estere, evidenziando la portata internazionale di questa ricerca di spicco.

Glossario Tecnico:

- Reti neurali profonde: Strutture di apprendimento automatico che utilizzano layer multipli per imparare rappresentazioni sempre più complesse dei dati.

- Fisica statistica: Branch della fisica che applica i principi statistici per comprendere il comportamento dei sistemi complessi.

- Parametri fondamentali: Caratteristiche chiave di una rete neurale, come la larghezza dei layer nascosti e le funzioni di attivazione.

- PNRR MNESYS: Piano Nazionale di Ripresa e Resilienza - Missione Nazionale Energia e Sistemi Sostenibili.

#RetiNeuraliProfonde #IAInnovativa #RicercaParma #FisicaStatistica

Questo studio dell'Università di Parma rivoluziona il modo in cui comprendiamo le reti neurali profonde, gettando le basi per un'applicazione più avanzata e consapevole dell'intelligenza artificiale. Mentre l'innovazione si fonde con la tradizione scientifica, ci si aspetta che questa teoria apra la strada a ulteriori scoperte nel campo dell'intelligenza artificiale, contribuendo così al progresso della tecnologia che permea sempre più la nostra vita quotidiana.

L'abstract del lavoro scientifico intitolato "A statistical mechanics framework for Bayesian deep neural networks beyond the infinite-width limit" presenta una prospettiva affascinante che combina la meccanica statistica con le reti neurali profonde basate su Bayes. Per comprendere appieno l'abstract, esaminiamo le sue componenti chiave:

- Principale Oggetto di Studio: Il lavoro si concentra sull'indagine delle reti neurali profonde (deep neural networks) basate su approcci Bayesiani, andando oltre i limiti di larghezza infinita (infinite-width limit). In termini più semplici, si occupa di esaminare reti neurali profonde che superano le semplificazioni idealizzate legate a dimensioni particolarmente grandi.

- Contesto Teorico: L'astrazione eccessiva che si verifica nei casi di larghezza infinita è una semplificazione ideale, ma distante dalla realtà pratica del deep learning. Qui, gli autori utilizzano il quadro della meccanica statistica, un campo della fisica che applica i principi statistici a sistemi complessi, per superare queste limitazioni.

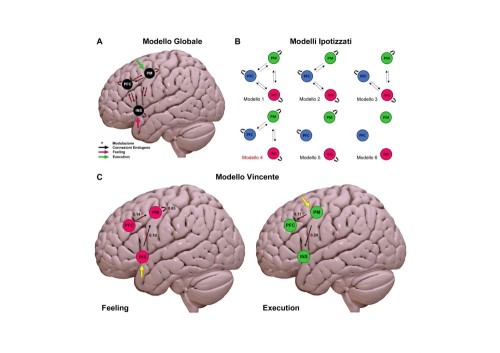

- Obiettivi: L'obiettivo principale è derivare una funzione di partizione approssimata per architetture di reti neurali profonde completamente connesse. Questa funzione di partizione codifica informazioni sui modelli addestrati e il calcolo si applica nel limite termodinamico, in cui sia il numero di unità nei vari strati nascosti sia il numero di esempi di addestramento sono grandi e il loro rapporto è finito.

Risultati Chiave:

Formula Chiusa per l'Errore di Generalizzazione: Per reti neurali con un solo strato nascosto e un rapporto finito tra esempi di addestramento e numero di unità nascoste, gli autori derivano una formula chiusa per l'errore di generalizzazione associato a compiti di regressione.

Espressione Approssimativa della Funzione di Partizione per Architetture Profonde: Gli autori propongono un'espressione approssimativa della funzione di partizione per architetture di reti neurali profonde, utilizzando un'azione efficace che dipende da un numero finito di parametri d'ordine.

Collegamento tra Reti Neurali Profonde e Processi di Student t: Si stabilisce un collegamento tra le reti neurali profonde nel limite asintotico proporzionale e i processi di Student t.

Rilevanza e Applicazioni: Questa avanzata teoria fornisce un nuovo modo di comprendere e analizzare le reti neurali profonde, superando le limitazioni concettuali dei modelli ideali. I risultati derivati possono avere implicazioni significative nell'applicazione pratica di queste reti in contesti di apprendimento automatico bayesiano.

In breve, l'abstract offre una panoramica chiara del contributo del lavoro scientifico, introducendo nuove prospettive per la comprensione teorica e l'applicazione pratica delle reti neurali profonde basate su approcci bayesiani. Cite this article - Pacelli, R., Ariosto, S., Pastore, M. et al. "Un quadro di meccanica statistica per reti neurali profonde bayesiane oltre il limite di larghezza infinita." Nat Mach Intell 5, 1497–1507 (2023). https://doi.org/10.1038/s42256-023-00767-6 - https://www.nature.com/articles/s42256-023-00767-6#citeas